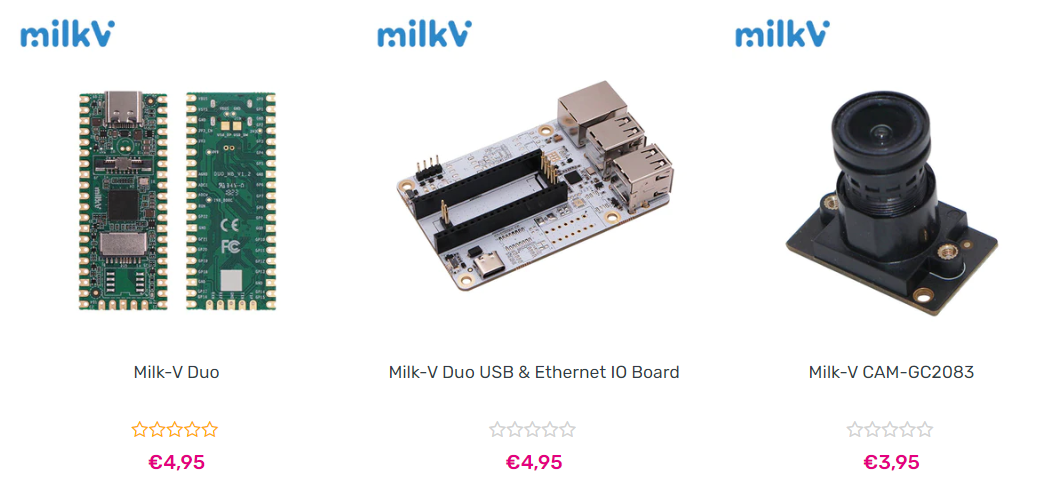

Milk-V Duo ist eine ultrakompakte Embedded-Entwicklungsplattform auf der Basis des CV1800B-Chips. Sie kann Linux und RTOS ausführen und bietet eine zuverlässige, kostengünstige und leistungsstarke Plattform für Profis, industrielle ODMs, IoT-Enthusiasten, Heimwerker und Entwickler. Spezifikation Milk-V Duo Specification Prozessor CVITEK CV1800B (C906@1Ghz + C906@700MHz) RAM DDR2 64MB Flash 1x Mirco SD slot,1x SD NAND solder pad USB 1x Type-C for data and Power,1x USB2 solder pad Kamera 1x 16P FPC connector (MIPI CSI 2-lane) GPIO up to 26 Pins available for general purpose I/O(GPIO) Größe 21mm*51mm Details:https://milkv.io/docs/duo/overview Größe Hier mal ein Größenvergleich des Milk-V & Cam mit meiner Logitech Maus. Shop https://arace.tech/search?q=Milk-V+Duo&type=product https://milkv.io/ Ich habe mal direkt zugeschlagen und mich mal eingedeckt. Ein erster Test zeigt, dass der Energiebedarf mit ca.…

Kommentare sind geschlossenKategorie: Allgemein

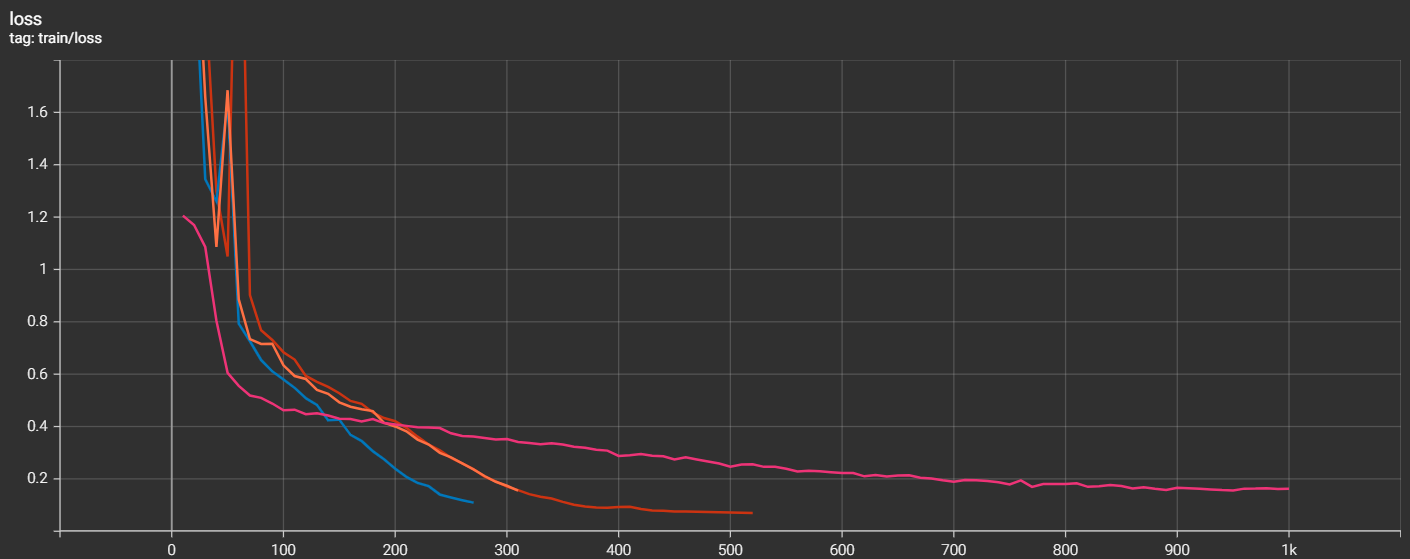

Base_model: TheBloke/CodeLlama-13B-Instruct-fp16Training_data: javadoc_v0.1.json (1.3GB Apache Commons Javadoc Dataset) Training Loss Validation Loss Der 4te Versuch war erfolgreich.

Kommentare sind geschlossenKünstliche Intelligenz wird zu einem immer relevanteren Thema, das die Welt im Sturm erobert. Von bahnbrechenden wissenschaftlichen Fortschritten bis hin zu erstaunlichen Anwendungen in unserem täglichen Leben hat AI das Potenzial, die Grenzen des Menschlichen zu erweitern und die Zukunft unserer Gesellschaft zu gestalten. In diesem Blog-Beitrag stelle ich eine Liste von zehn Videos vor, die mich in den letzten Wochen und Monaten motiviert haben, mich noch tiefer in das Kaninchenloch zu begeben. Bei den Videos handelt es sich nicht um Technik-Videos zu diesen Themen, sondern eher um ganz allgemeine Videos, die man sich einfach mal in Ruhe ansehen sollte. Die Videos sind für Technologie-Enthusiasten, ein Entwickler, Unternehmer und Jeden, der Einblicke in die Welt der KI und ihrer faszinierenden…

Kommentare sind geschlossenSeit gestern besitze ich einen Jetson Orin 64GB. Als erstes habe ich mal getestet, wie gut die Performance der GPU ist. Dafür habe erst mal Tensorflow 2.9.1 mit GPU-Unterstützung installiert und einen Benchmark laufen lassen, den ich hier kopiert habe. Hier das Benchmark Skript das ich für meinen Test genutzt habe. Die folgenden System habe ich miteinander verglichen. Jetson Orin 64GB – Mode = MAX entry { name: „TensorFlowBenchmark.run_op_benchmark“ iters: 10 wall_time: 0.003049612045288086 extras { key: „allocator_maximum_num_bytes_GPU_0_bfc“ value { double_value: 12582912.0 } } extras { key: „allocator_maximum_num_bytes_gpu_host_bfc“ value { double_value: 8.0 } } } Google Colab T4 GPU entry { name: „TensorFlowBenchmark.run_op_benchmark“ iters: 10 wall_time: 0.001888871192932129 extras { key: „allocator_maximum_num_bytes_GPU_0_bfc“ value { double_value: 12582912.0 } } extras { key: „allocator_maximum_num_bytes_gpu_host_bfc“…

Kommentare sind geschlossenUnter https://www.learndatasci.com/books/ gibt es eine umfangreiche Sammlung von über 100 kostenlosen Büchern zu den verschiedensten Aspekten der Datenwissenschaft. Egal, ob es um Data Science, Big Data, Datenvisualisierung, Data-Mining, maschinelles Lernen, Python, R oder anderen relevanten Themen geht – auf dieser Webseite wird man fündig!

Kommentare sind geschlossenChatGPT kann komplexe und umfangreiche Antworten auf eine Vielzahl von Fragen generieren und hat das Potenzial, die Art und Weise, wie wir mit Computern und anderen Technologien (z.B. Robotern) interagieren, zu verändern. Aber wie abhängig sind wir schon heute von ChatGPT, Midjourney und anderen generativen KIs? Naja, es kommt darauf an. ChatGPT ist ein Werkzeug, das uns helfen kann, schneller und effizienter zu arbeiten. Es kann dabei helfen, Antworten auf Fragen zu finden, oder bei der Erledigung von Aufgaben unterstützen. Mittelfristig besteht allerdings die Gefahr, dass wir uns zu sehr darauf verlassen und unsere Fähigkeiten zur Lösung von Problemen ohne die Unterstützung von ChatGPT und Co. verlieren. Daher ist es wichtig, daran zu denken, dass ChatGPT nur ein Werkzeug ist…

Kommentare sind geschlossenIn einem Talk redet Prof. Nadav Cohen an der Tel Aviv University’s Blavatnik School of Computer Science mit Sam Altman, dem CEO von OpenAI, und dem Mitbegründer und Chefwissenschaftler des Unternehmens, Ilya Sutskever. Ab ca. Minute 21 geht es dann um dann um das Thema Klimaschutz und ich bin etwas irritiert. Tel Aviv University Sam Altman and Ilya Sutskever Transcript Auszug des Talk ab ca. Minute 21. Sam Altman:I think once we have a really powerful super intelligence addressing climate change will not be particularly difficult for a system like that. Ilya Sutskever:We can even explain how. Here’s how you solve climate change. You need a very large amount of efficient carbon capture, you need the energy for the carbon…

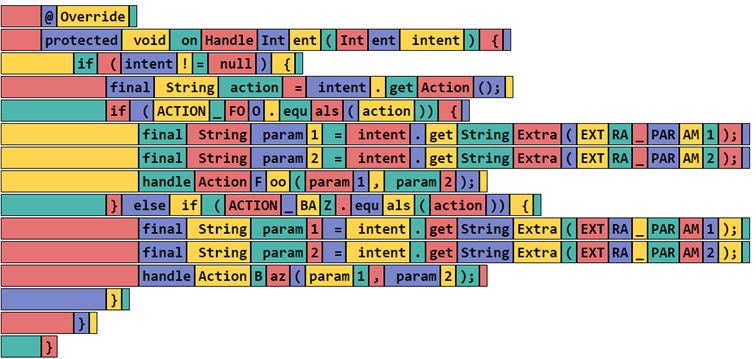

Kommentare sind geschlossenEin Tokenizer ist eine Komponente von Large Language Models (LLMs) die dazu dient, einen Text in Token zu zerlegen (encoding) und die Token wieder in einen lesbaren Text umzuwandeln (decoding). Ohne einen Tokenizer ist die Verarbeitung von natürlicher Sprache in den aktuell verfügbaren LLMs nicht möglich, da sie nur Token verarbeiten können. Das grundlegende Konzept des Tokenizers besteht darin, einen Text in kleinere Einheiten zu zerlegen und in Zahlen umzuwandeln. Anstatt den gesamten Text als eine zusammenhängende Zeichenkette zu betrachten, wird er in kleine Einheiten wie Wörter, Subwörter oder sogar einzelne Zeichen unterteilt. Dieser Prozess ermöglicht es dem LLM, die verschiedenen Bestandteile eines Textes besser zu verstehen und in Beziehung zueinander zu setzen. Statt Wörter als Einheiten zu betrachten, werden…

Kommentare sind geschlossenIn dem YouTube Video „Der einzige Prompt, den Du kennen musst.“ wird ein ChatGPT Prompt gezeigt. mit dem es möglich ist, ein Frage-Antwort Dialog mit ChatGPT zu führen, um einen möglichst guten Prompt für eine bestimmte Aufgabe zu entwickeln. Dabei stellt ChatGPT immer wieder Fragen, die man beantwortet, um den Prompt immer weiter zu verfeinern. Das geht so lange, bis man einen Prompt erstellt hat, der dann wieder in ein neues ChatGPT Fenster kopiert werden kann, um dann eine Antwort zu bekommen. Zusammenfassung Highlights Hier der Prompt „Ich möchte, dass du mein Prompt Creator wirst. Dein Ziel ist es, mir zu helfen, den bestmöglichen Prompt für meine Bedürfnisse zu erstellen. Der Prompt wird für ChatGPT erstellt. Du wirst den folgenden…

Kommentare sind geschlossenDiese Frage wird immer wieder gerne gestellt, wenn es um nicht-technische Themen rund um das Thema geht. Besonders gerne stellen „kreative/schaffende“ Personen diese Frage, die eine natürliche Skepsis gegenüber der KI haben und Tools wie z.B. Midjourney und ChatGPT eher als Konkurrenz ansehen. Die Antwort darauf ist aber nicht so ganz einfach. Man kann sie nicht mit 100% Sicherheit beantworten und für beide Möglichekiten gibt es gute Argumente. Denn eine KI, wie sie hinter wie Midjourney und ChatGPT stehen, kann nur existierendes neu kombinieren und erschafft damit nur etwas, das eine Kombination aus etwas Existierendem ist – ist das etwas Neues? Evtl. hilft eine andere Sichtweise auf die aktuelle Situation etwas, um besser vorstellen zu können, wo wir denn heute…

Kommentare sind geschlossen