Weil die Online Dienste nicht immer verfügbar sind.

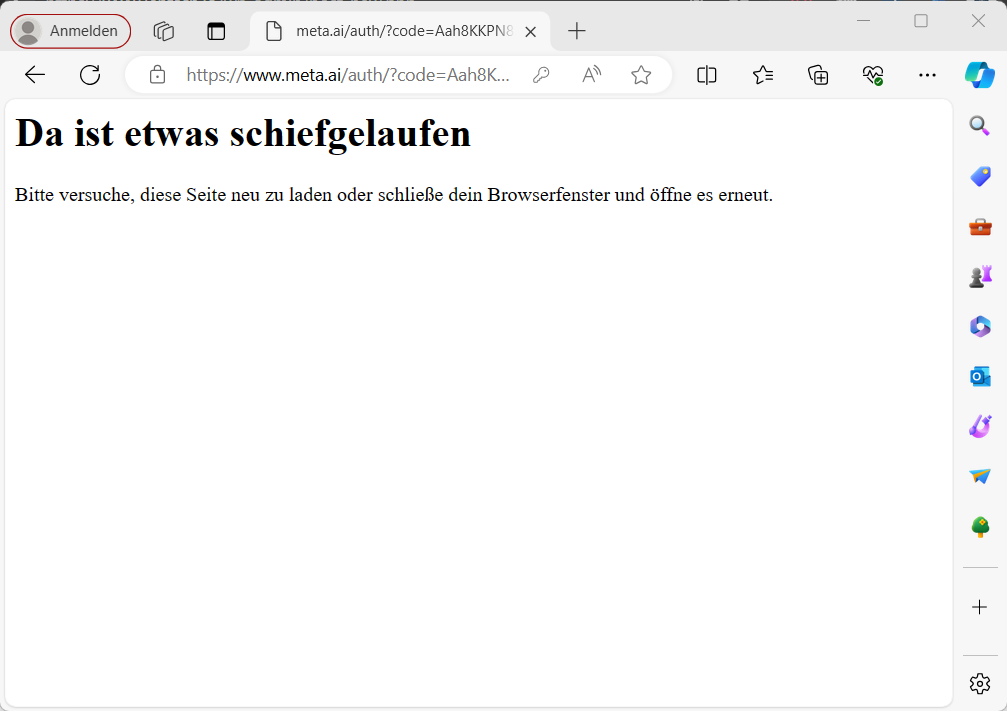

Da ist etwas schiefgelaufen

Bitte versuche, diese Seite neu zu laden oder schließe dein Browserfenster und öffne es erneut.

https://www.meta.ai/

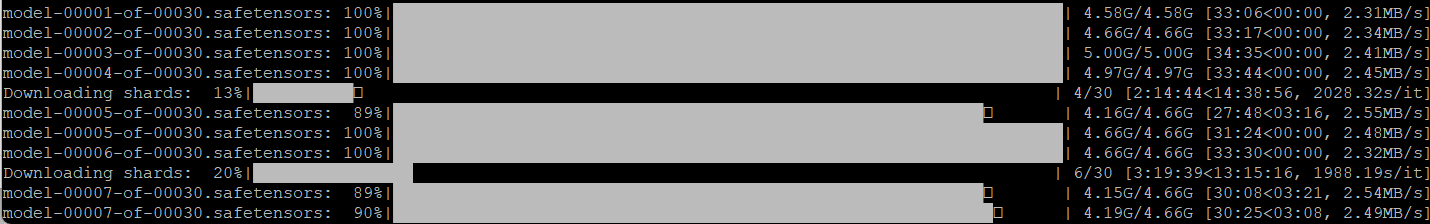

Das zeigt mir gerade die meta.ai Webseite. Habe es mit unterschiedlichen Browsersn und auf verschiedenen Computern versucht – leider ohne Erfolg. Also bleibt nur, Meta-Llama-3-70B-Instruct herunterladen und in 4-Bit auf dem Jetson Orin Dev. Board laufen lassen. Leider ist der Download sehr groß und ich kann das Meta-Llama-3-70B-Instruct noch nicht lokal laufen lassen, da der Download noch ca. 25 Stunden benötigt. 🙁

Also abwarten und Tee trinken …..